Roboter læres opp til å utføre stadig mer kompliserte husholdningsoppgaver, fra å tørke opp søl til å servere mat. Mange av disse robotene lærer gjennom imitasjon, det vil si at de programmeres til å kopiere bevegelsene som et menneske fysisk leder dem gjennom.

Det viser seg at roboter er gode til å imitere. Men med mindre ingeniører også programmerer dem til å tilpasse seg alle mulige humper og dytt, vet ikke robotene nødvendigvis hvordan de skal håndtere slike situasjoner, med mindre de starter fra begynnelsen.

Nå prøver MIT-ingeniører å gi roboter litt sunn fornuft når de står overfor situasjoner som bringer dem ut av den opplærte banen. De har utviklet en metode som kobler sammen robotens bevegelsesdata med “sunn fornuft-kunnskap” fra store språkmodeller, eller LLM-er.

Tilnærmingen gjør det mulig for en robot å logisk analysere mange gitte husholdningsoppgaver i deloppgaver og fysisk tilpasse seg forstyrrelser i en deloppgave, slik at roboten kan gå videre uten å måtte gå tilbake og starte en oppgave fra bunnen av – og uten at ingeniørene eksplisitt må programmere løsninger for alle mulige feil underveis.

“Imitasjonslæring er en vanlig tilnærming for husholdningsroboter. Men hvis en robot blindt imiterer et menneskes bevegelsesbaner, kan små feil hope seg opp og til slutt ødelegge resten av utførelsen”, sier Yanwei Wang, doktorgradsstudent ved MITs avdeling for elektroteknikk og datavitenskap (EECS). “Med vår metode kan roboten selv korrigere utførelsesfeil og forbedre den totale oppgaveløsningen.”

Wang og kollegene hans beskriver den nye tilnærmingen i en studie som de vil presentere på International Conference on Learning Representations (ICLR) i mai. Studiens medforfattere inkluderer EECS-studentene Tsun-Hsuan Wang og Jiayuan Mao, Michael Hagenow, postdoktor ved MITs avdeling for aeronautikk og astronautikk (AeroAstro), og Julie Shah, H.N. Slater-professor i aeronautikk og astronautikk ved MIT.

Språklig oppgave

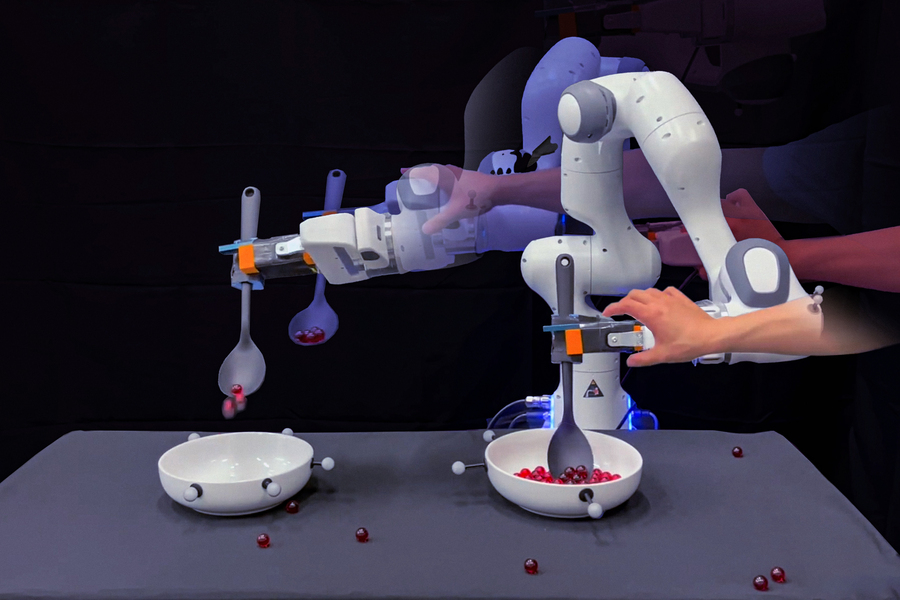

Forskerne illustrerer den nye tilnærmingen med en enkel oppgave: å øse klinkekuler fra en bolle og helle dem over i en annen. For å utføre denne oppgaven ville ingeniører vanligvis beveget en robot gjennom bevegelsene for å øse og helle – alt i én og samme bane. De kan gjøre dette flere ganger for å gi roboten en rekke menneskelige demonstrasjoner å etterligne.

“Men den menneskelige demonstrasjonen er én lang, sammenhengende bane”, sier Wang.

Teamet innså at selv om et menneske kan demonstrere én enkelt oppgave på én gang, er denne oppgaven avhengig av en rekke deloppgaver eller baner. For eksempel må roboten først strekke seg inn i en bolle før den kan øse, og den må øse opp klinkekuler før den beveger seg til den tomme bollen, og så videre. Hvis en robot blir dyttet eller dyttet til å gjøre en feil under en av disse deloppgavene, er dens eneste utvei å stoppe og begynne forfra, med mindre ingeniørene eksplisitt merker hver deloppgave og programmerer eller samler inn nye demonstrasjoner for at roboten skal kunne rette opp feilen, slik at den kan korrigere seg selv i øyeblikket.

“Et slikt planleggingsnivå er veldig kjedelig”, sier Wang.

I stedet fant han og kollegene ut at noe av dette arbeidet kunne gjøres automatisk av LLM-er. Disse dyplæringsmodellene behandler enorme tekstbiblioteker som de bruker til å etablere forbindelser mellom ord, setninger og avsnitt. Ved hjelp av disse forbindelsene kan en LLM-modell generere nye setninger basert på det den har lært om hva slags ord som sannsynligvis vil følge etter det forrige.

Forskerne fant ut at i tillegg til setninger og avsnitt kan en LLM bli bedt om å lage en logisk liste over deloppgaver som inngår i en gitt oppgave. Hvis en LLM for eksempel blir bedt om å liste opp handlingene som er involvert i å øse klinkekuler fra en bolle til en annen, kan den produsere en sekvens av verb som “nå”, “øse”, “transportere” og “helle”.

“LLM-er har en måte å fortelle deg hvordan du skal utføre hvert trinn i en oppgave på, i et naturlig språk. Et menneskes kontinuerlige demonstrasjon er legemliggjøringen av disse trinnene i det fysiske rommet”, sier Wang. “Og vi ønsket å koble de to sammen, slik at en robot automatisk vet hvor langt den er kommet i en oppgave, og kan planlegge på nytt og gjenopprette på egen hånd.”

Kartlegging av klinkekuler

I den nye tilnærmingen har teamet utviklet en algoritme som automatisk kobler en LLMs naturlige språkbetegnelse for en bestemt deloppgave med robotens posisjon i det fysiske rommet eller et bilde som koder for robotens tilstand. Å koble en robots fysiske koordinater, eller et bilde av robotens tilstand, til en naturlig språkmerking kalles “grounding”. Teamets nye algoritme er designet for å lære en “klassifiserer”, noe som betyr at den lærer seg å automatisk identifisere hvilken semantisk deloppgave en robot er i – for eksempel “strekke seg” versus “øse” – gitt dens fysiske koordinater eller et bilde.

“Grounding-klassifiseringen legger til rette for denne dialogen mellom det roboten gjør i det fysiske rommet og det LLM vet om deloppgavene, og de begrensningene du må ta hensyn til innenfor hver deloppgave”, forklarer Wang.

Teamet demonstrerte tilnærmingen i eksperimenter med en robotarm som de trente på en oppgave med å hente klinkekuler. Eksperimentatorene trente roboten ved å fysisk lede den gjennom oppgaven med først å strekke seg ned i en bolle, øse opp klinkekuler, transportere dem over en tom bolle og helle dem oppi. Etter noen demonstrasjoner brukte teamet en forhåndsopplært LLM og ba modellen om å liste opp stegene som var involvert i å øse klinkekuler fra en bolle til en annen. Forskerne brukte deretter den nye algoritmen til å koble LLM-modellens definerte deloppgaver med robotens bevegelsesdata. Algoritmen lærte automatisk å tilordne robotens fysiske koordinater i bevegelsesbanene og den tilhørende bildevisningen til en gitt deloppgave.

Teamet lot deretter roboten utføre øseoppgaven på egen hånd ved hjelp av de nyinnlærte klassifisererne. Etter hvert som roboten beveget seg gjennom trinnene i oppgaven, dyttet og dyttet eksperimentatorene roboten ut av banen og slo klinkekuler av skjeen på ulike steder. I stedet for å stoppe og begynne forfra igjen, eller fortsette i blinde uten klinkekuler på skjeen, var roboten i stand til å korrigere seg selv og fullføre hver deloppgave før den gikk videre til neste. (Den forsikret seg for eksempel om at den hadde lykkes med å øse opp klinkekulene før den transporterte dem til den tomme skålen).

“Når roboten gjør feil med vår metode, trenger vi ikke å be mennesker om å programmere eller gi ekstra demonstrasjoner av hvordan den skal rette opp feil,” sier Wang. “Det er kjempespennende, for det gjøres nå en stor innsats for å trene opp husholdningsroboter med data som er samlet inn på teleoperasjonssystemer. Algoritmen vår kan nå konvertere disse treningsdataene til robust robotatferd som kan utføre komplekse oppgaver til tross for eksterne forstyrrelser.”